Intelligence artificielle : l'inquiétude du Prix Nobel de physique et des scientifiques

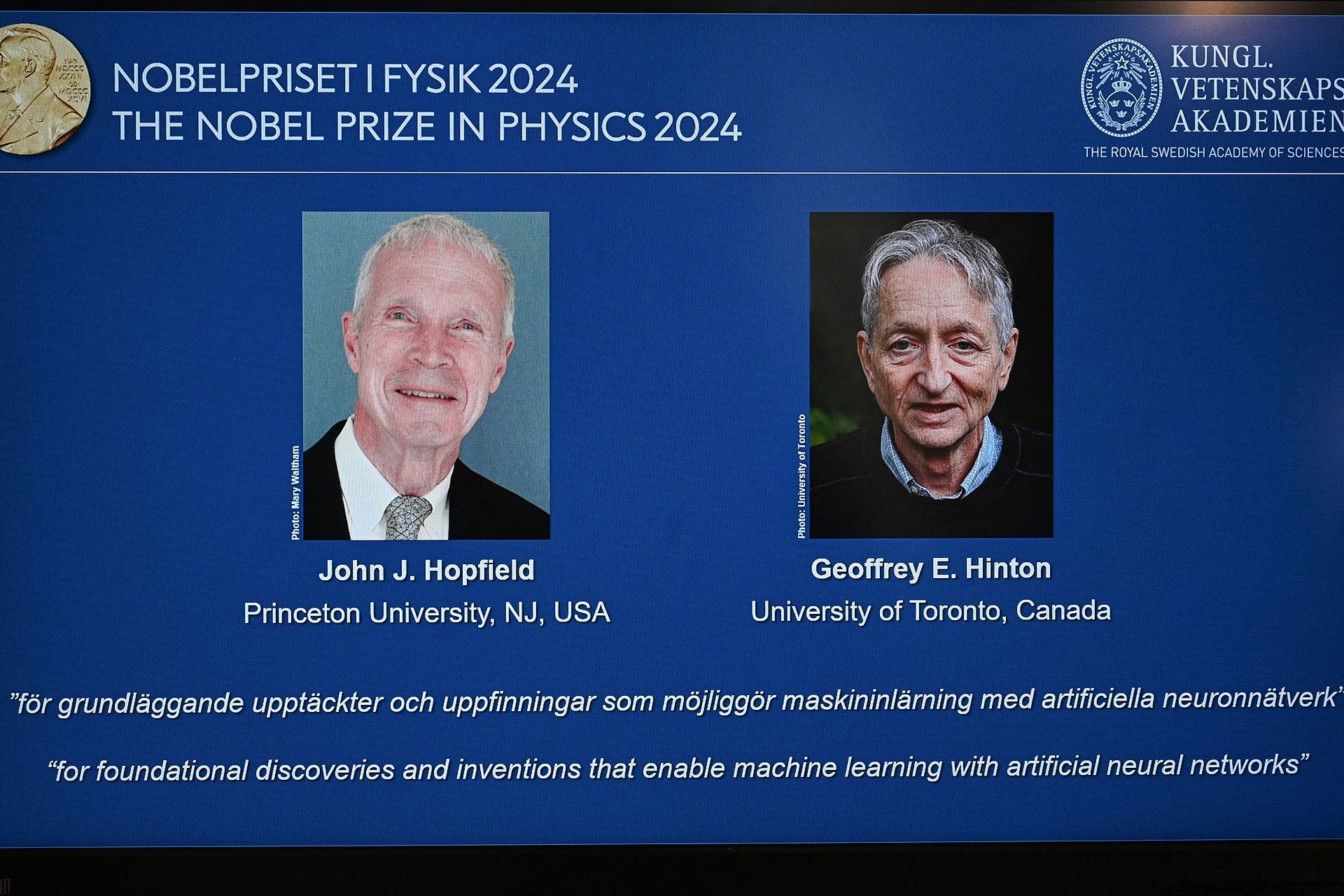

Co-lauréat du Prix Nobel de physique cette année, le scientifique britanno-canadien Geoffrey Hinton s'est inquiété des possibles dérives de l'intelligence artificielle.

Hinton a été récompensé pour ses travaux pionniers sur les réseaux de neurones artificiels, une copie du fonctionnement du cerveau humain qui permet aux machines d'apprendre de manière autonome. Mais il semble aujourd'hui craindre sa propre création.

"Nous n'avons jamais côtoyé quelque chose de plus intelligent que nous. Ce serait formidable sur de nombreux aspects, mais je crains que la conséquence globale de tout cela ne soit des systèmes plus intelligents que nous, qui finissent par prendre le contrôle", a affirmé le scientifique, repris par France Info.

"En tant que physicien, je suis très troublé par quelque chose qui n’est pas contrôlé, quelque chose que je ne comprends pas assez bien pour savoir quelles sont les limites que l’on peut imposer à cette technologie", a-t-il ajouté, comme l'indique Le Monde.

Ce n'est pas la première fois que des spécialistes de cette technologie s'inquiètent de possibles dérives de l'IA. En mars 2023, une lettre ouverte intitulée ''Interrompre les expériences géantes en matière d'IA'' avait été diffusée sur le site de l'organisation Future of Life Institute. La missive avait été cosignée par plus de 1 000 dirigeants d'entreprises et de sociétés technologiques.

La lettre invitait les laboratoires à suspendre immédiatement (et de manière temporaire) la formation des systèmes d'intelligence artificielle plus avancés que GPT-4. Selon les nombreux scientifiques et spécialistes du milieu, l'IA se développerait bien trop vite.

Ainsi, on pouvait lire au début de la lettre que ''les systèmes d’IA dotés d’une intelligence compétitive avec celle des humains peuvent présenter des risques profonds pour la société et l’humanité.''

Les signataires affirmaient que "les développeurs d'IA sont engagés dans une course incontrôlée pour développer et déployer des esprits numériques de plus en plus puissants".

Le problème de cette évolution est que, selon la missive, "même ses créateurs ne peuvent pas comprendre, prédire ou même contrôler de manière fiable" la direction qu'elle est en train de prendre.

Parmi les signataires figuraient des noms illustres comme Elon Musk, Steve Wozniak (cofondateur d'Apple, sur la photo) et Craig Peters (le président directeur général de Getty Images).

Parmi les propositions formulées dans la lettre ouverte figure "l'introduction de protocoles de sécurité".

"Si une telle pause ne peut être adoptée rapidement, les gouvernements devraient intervenir et instaurer un moratoire", affirmaient-ils.

Photo : Unsplash - Andy Kelly

Selon les signataires, les chatbots tels que ChatGPT, Bing et Bard sont rendus à un tel niveau de développement qu'ils sont en mesure de déterminer qui seront les prochains leaders de l'industrie technologique.

Photo : Unsplash - Boitumelo Phetla

Pour rendre les choses un peu plus difficiles, les auteurs soulignaient que ces outils se sont montrés défectueux à certains niveaux de détail et qu'ils ont une énorme capacité à diffuser des informations erronées.

Photo : Unsplash - Drew Dizzy Graham

Parmi les risques identifiés dans la lettre ouverte figurent les "hallucinations". En réalité, ce sont des informations et des données fournies par l'IA qui semblent fiables, mais qui sont en fait erronées.

Photo : Unsplash - Maximalfocus

En substance, les signataires appelaient à un développement durable et organique de l'IA, en la développant "uniquement lorsque nous sommes sûrs que ses effets seront positifs et que ses risques seront gérables".

Photo : Unsplash - Jonathan Kemper

"L'humanité peut bénéficier d'un avenir florissant grâce aux systèmes d'IA puissants et nous pouvons tous en profiter", remarquaient les experts.

Photo : Unsplash - Lukas

Cependant, les signataires étaient conscients que la communauté technologique n'accepterait pas dans son ensemble un tel moratoire et que l'option consistant à légiférer sur l'intelligence artificielle était trop compliquée.

Photo : Unsplash - Nguyen Dang Hoang Nhu

Avec le prestige offert par un Prix Nobel de physique, le camp des sceptiques sur l'IA s'est encore renforcé. Cette technologie pourra-t-elle être maîtrisée ou va-t-elle provoquer des évolutions irréversibles pour l'humanité ?

Et aussi

À ne pas manquer